La recente ondata di innovazioni basate sull’Artificial Intelligence sembra interessare in maniera sempre più pervasiva fenomeni che fino a qualche tempo fa si ritenevano ancora dominio esclusivo degli “umani”…

Si passa quindi (apparentemente senza alcuna difficoltà) dal riconoscimento delle emozioni alla attribuzione di “consapevolezza” alle macchine.

In realtà, come spesso capita, l’apparenza inganna e può dare origine a fenomeni allucinatori scambiati per reali…

Le emozioni sono negli occhi di chi vede

In principio è stato Blake Lemoine, con i suoi bot supposti senzienti; in seguito (o in contemporanea, fate voi) fece la sua apparizione sulla scena mediatica il robot che riconosce le emozioni, il tutto sotto gli occhi stupiti degli spettatori increduli.

E la presenza di un pubblico di spettatori è tutt’altro che di secondaria importanza, non solo per la riuscita della diffusione del messaggio commerciale sotteso alle “innovazioni” tecnologiche all’ultimo grido, ma anche per il successo del gioco di prestigio che riguarda nello specifico le macchine e le loro presunte “capacità cognitive”:

le emozioni e la senzienza delle macchine risiedono infatti nell’occhio di chi le vede e le vuole vedere…

Distinguere i volti e le emozioni autentiche è cosa umana, troppo umana

Non a caso, quello di Lemoine può essere derubricato a un comune esempio di pareidolia ovvero idoli apparenti, rappresentanti immagini create dalla mente, scambiate per oggetti reali.

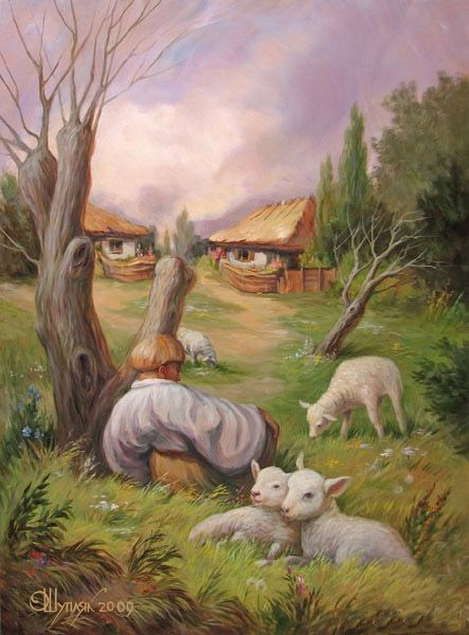

Per questo motivo si parla anche di allucinazioni visive, anche se spesso si tratta di fenomeni comuni, come il riconoscere volti tra le nuvole (un gioco a cui si prestano in tutta tranquillità adulti e bambini), riconducibile alla capacità umana di riconoscere forme e oggetti (gestalt), sfruttata con maestria anche da artisti quali Oleg Shuplyak nelle proprie opere suggestive:

La presenza di uno spettatore umano è quindi essenziale non solo per riconoscere forme e oggetti nel mondo esterno, ma anche per riconoscere la presenza di emozioni in altri soggetti.

Una macchina che non è in grado (almeno fino a prova contraria) di esperire emozioni autentiche, ben difficilmente saprà riconoscerne di altrettanto autentiche in altri soggetti.

In altri termini, solo chi è dotato di emozioni e consapevolezza è in grado di riconoscerne la presenza in altri soggetti, poichè ciò presuppone appunto la capacità di immedesimarsi negli altri…

I simulacri digitali dell’AI spacciati per evidenze oggettive

Proprio il fenomeno della pareidolia ci conduce al concetto dei “simulacri”, stavolta però utilizzato con riferimento a tutti quegli idoli che sono creati e proposti in sostituzione di altri idoli, anzichè di oggetti reali.

In maniera illuminante, Wikipedia definisce i simulacri come segue:

Così come il volto riconosciuto tra le nuvole è in realtà frutto dell’immaginazione, allo stesso modo si finisce per confondere gli artefatti digitali utilizzati dalle macchine come elementi sostitutivi delle realtà rappresentate, in un ennesima confusione tra mappa e territorio.

In altre parole, si confondono le emozioni con le loro manifestazioni fisiologiche esteriori, e a queste si pretende di sostituire gli artefatti digitali prodotti dalla macchina per rappresentarli.

Si tratta quindi di idoli di idoli; “simulacri digitali” appunto…

Sfruttando i “simulacri” (digitali o meno che siano) si possono ingannare non soltanto i robot e le macchine “cognitive”, ma anche gli umani:

un attore esperto ben potrebbe ingannare una macchina, così come comunemente inganna un umano, facendole credere di provare determinate emozioni a proprio piacimento.

Tuttavia, nel caso degli umani, questi solitamente vengono coinvolti dalla performance dell’attore in un’esperienza emotiva alla quale spesso si sottopongono volontariamente disponendosi per alcune ore davanti alla tv, oppure andando a cinema o a teatro.

Nel caso della macchina, invece, questa potrebbe “convincersi” di aver individuato nelle movenze facciali e sensoriali associate al soggetto analizzato delle possibili “devianze” o comportamenti presunti “antisociali” (magari riconducibili a innocue pantomime), e classificare di conseguenza come “sospetti” soggetti che in realtà non lo sono affatto, spacciando inoltre tali illazioni come evidenze “oggettive” (roba da fare impallidire la ormai screditata “macchina della verità”…)

Lombroso alla riscossa

In maniera più prosaica, possiamo dire che queste trovate in salsa “digimagical” sembrano aver riportato prepotentemente in auge Cesare Lombroso e le sue screditate teorie “scientifiche”, che al contrario si ritenevano ormai archiviate, proprio perchè carenti di qualsiasi evidenza e rigore scientifico.

Secondo Lombroso, era possibile riconoscere i criminali analizzandone le caratteristiche anatomiche, che manifestavano gli “atavismi ereditari” ritenuti responsabili della condotta criminale del soggetto.

Come dire che il criminale lo porta scritto in fronte di essere tale…

Queste “teorie” risentivano del clima intellettuale dell’epoca, un miscuglio indigeribile di fisiognomica (che pretendeva di dedurre i caratteri psicologici e morali di una persona dal suo aspetto fisico, soprattutto dai lineamenti e dalle espressioni del volto), frenologia (secondo cui dalla morfologia del cranio di una persona si potrebbe giungere alla determinazione delle qualità psichiche dell’individuo e della sua personalità) e positivismo (concezione secondo cui l’unica manifestazione scientifica della realtà era quella riconducibile ai fenomeni ‘positivi’ concretamente visibili, tutto il resto era derubricabile come “sogno metafisico”).

Proprio il ritorno al positivismo (ovvero quel movimento scientifico-filosofico ispirato all’illuminismo, di cui condivide la fiducia nella scienza e nel progresso scientifico-tecnologico, che vede nella progressiva affermazione della ragione la base del progresso o evoluzione sociale), sembra essere alla base delle attuali concezioni che caratterizzano l’Artificial Intelligence.

Concezioni che si ritenevano essere ormai archiviate nel ciarpame delle teorie scientifiche, e che invece sembrano essere state riesumate in forma surrettizia proprio dalle recenti “innovazioni” che vedono protagonista la tanto sbandierata “intelligenza” artificiale e i sui supposti rimedi salvifici ad ogni problema dell’umanità, mascherati dietro un’aurea di “oggettività” che non è altro che la riedizione contemporanea della visione positivista della scienza.

Ma si sa, nel momento in cui a farla da padrone sono il marketing e il sensazionalismo mediatico, anche “teorie” squalificate dalla storia possono tornare a far comodo…

© Alessandro Parisi - All rights reserved - Riproduzione Riservata