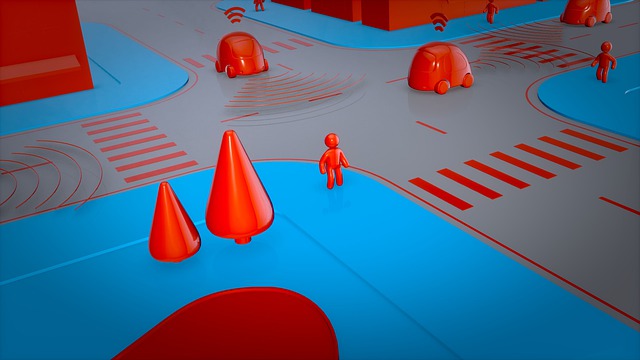

Le responsabilità nascoste delle automobili a guida autonoma

Tra gli aspetti controversi (e francamente ce ne sono molti) che riguardano il prevedibile e sempre più pervasivo impiego in un futuro non troppo lontano, delle self-driving cars, ce ne è uno che rimane spesso sottaciuto e relegato sullo sfondo:

La questione ha assunto carattere di attualità non solo a seguito dell’investimento di passanti (evento avveratosi con esiti tragici già nel marzo 2018, e ripetutosi più di recente nell’aprile 2021) da parte di una self-driving car di Uber, ma soprattutto in relazione alla presunta “intelligenza” che caratterizzerebbe tali dispositivi, solo per pura assonanza accostabile alle capacità intellettive umane, non tanto in termini di capacità di previsione degli esiti possibili, quanto piuttosto in termini di scelta e decisione.

L’impiego di tecnologie che demandano alle macchine compiti e intenzionalità una volta appannaggio esclusivo degli esseri umani, solleva per forza di cose la questione (e il relativo timore) di una possibile progressiva e generale deresponsabilizzazione indotta dalla società tecnologizzata.

Le questioni etiche irrinunciabili

L’introduzione delle self-driving cars lasciano sullo sfondo diverse questioni che implicano scelte etiche che difficilmente sono implementabili negli automatismi.

Di fronte alla scelta tra l’evitare un incidente e investire un passante, quale “decisione” prenderà ad es. una self-driving car?

Le responsabilità delle scelte automatizzate dei veicoli devono essere ricondotte al produttore della macchina “intelligente”, oppure al proprietario della stessa, come accade attualmente nei comuni incidenti stradali (coperti peraltro da polizze assicurative obbligatorie)?

Senza voler evocare suggestioni fantascientifiche (in stile “Trilogia della Fondazione” di I. Asimov), occorre sottolineare come la capacità di scelta non implichi solo questioni “razionali”, suscettibili di essere emulate da algoritmi, ovvero problemi di corrette stime e previsioni (ad es. sulla direzione di marcia da prendere, o sul corretto angolo di sterzata e relativa accelerazione da imprimere al veicolo, ecc.), compiti nei quali le capacità computazionali delle macchine hanno dimostrato di surclassare ampiamente quelle degli esseri umani.

Al contrario, si tratta di comprendere che molte delle scelte e decisioni che comunemente siamo chiamati a prendere quotidianamente (spesso senza rendercene conto) implicano inevitabilmente valutazioni di natura etica.

Il timore è che in questo modo si demandino alle macchine non solo i compiti (siano essi “ripetitivi” o “predittivi”, a seconda dei casi) per i quali esse sono state progettate, ma anche quelle scelte la cui responsabilità (ci piaccia o meno) è e rimane irrimediabilmente nostra, in quanto esseri coscienti e consapevoli.

Davvero la guida autonoma è più sicura?

Una delle convinzioni più diffuse riguardanti l’Artificial Intelligence è quella che sostiene che gli algoritmi sarebbero meno soggetti ad errori di valutazione rispetto agli umani, e che pertanto andrebbero demandate ad essi anche quelle attività che comunemente sono appannaggio degli operatori umani.

Tra gli esempi solitamente addotti a supporto di tale tesi, vi è appunto quello della guida autonoma (self-driving).

Anche di fronte a casi come quello dell’investimento di un passante da parte di una autovettura a guida (semi) autonoma di Uber, avvenuto nel marzo del 2018, e che ha portato alla morte della vittima, i sostenitori della superiorità degli algoritmi sono comunque propensi a ritenere che la colpa sia da ricondurre ad un errore umano, piuttosto che agli algoritmi stessi.

Ma le cose stanno davvero così?

La ricostruzione dell’incidente

Da una ricostruzione della dinamica dell’incidente summenzionato, le colpe sarebbero infatti riconducibili da un lato ai comportamenti imprudenti tenuti dalla vittima, e dall’altro alla scarsa tempestività del co-pilota nel prendere il comando della vettura.

Tale ricostruzione tuttavia sottostima le conseguenze negative della possibile presenza di “bachi” nel software, oltrechè dei limiti metodologici di fondo che caratterizzano gli algoritmi utilizzati nella guida autonoma.

Svelare i limiti degli algoritmi che presiedono alla guida autonoma degli autoveicoli ci consente altresì di svelare i limiti associati al processo decisionale automatizzato, al fine di prevenire i potenziali rischi per l’incolumità fisica.

Perchè gli algoritmi di guida autonoma non sono meno rischiosi

Come gli esperti di tecnologie digitali amano spesso ripetere, viviamo in un’epoca guidata dai dati (data driven).

La disponibilità crescente di grandi moli di dati (e la capacità di elaborarli) ha permesso lo sviluppo di servizi fino a poco tempo fa inimmaginabili.

Gli algoritmi si sono evoluti al punto di riuscire a sfruttare la crescente quantità di dati disponibili, rendendo possibili servizi avanzati che vanno dalla ricerca intelligente dei contenuti, alla individuazione delle località di maggior interesse sfruttando la geolocalizzazione, alla traduzione automatica dei testi in diverse lingue.

Per quanto il livello di precisione dei risultati ottenuti tramite tali servizi “intelligenti” cresca di giorno in giorno, essi tuttavia non sempre forniscono risultati ottimali.

Pensiamo ai servizi di traduzione automatica dei testi: in molti casi i risultati delle traduzioni sono strabilianti, in altri casi sono invece imprecisi, specie in presenza di contenuti ambigui o di difficile interpretazione per la macchina.

In questi casi, si ricorre all’intuito umano per cercare di interpretare correttamente i risultati ottenuti dalla macchina.

Stesso dicasi per i risultati ottenuti dai motori di ricerca, che spesso forniscono risposte fuorvianti o non appropriate.

Sarà compito dell’utente raffinare ulteriormente la ricerca, al fine di ottenere risultati in linea con le aspettative della ricerca, oppure filtrare adeguatamente i risultati ottenuti eliminando quelli non considerati di interesse.

Il grado di precisione ottenuto dalle previsioni degli algoritmi data-driven avrà un impatto differente a seconda dei diversi contesti.

Nel caso delle traduzioni automatiche, anche un livello di precisione insoddisfacente sarà tuttavia utile agli scopi che ci prefissiamo, come ad esempio farci comprendere dal nostro interlocutore straniero.

Non altrettanto quando dalla precisione dei risultati possa dipendere la nostra incolumità fisica, come nel caso delle self-driving cars.

Se gli algoritmi danno la risposta giusta per i motivi sbagliati

Uno degli aspetti più controversi che caratterizza gli algoritmi è costituito dalla irragionevole affidabilità ad essi attribuita, determinata dall’innegabile efficacia predittiva associata ai dati.

In altri termini: la fiducia che viene riconosciuta alle capacità predittive degli algoritmi è diretta conseguenza dell’efficacia predittiva ritraibile dai dati stessi.

Proprio l’efficacia predittiva dei dati ha ispirato il recente paradigma decisionale “data-driven” (guidato dai dati).

Tuttavia, non sempre tale efficacia predittiva ci autorizza a fidarci ragionevolmente dei risultati ottenuti dalle procedure automatizzate “guidate dai dati”.

Efficacia predittiva non sempre è sinonimo di affidabilità

Per rendersene conto, basta prendere in considerazione i risultati ottenuti utilizzando uno degli strumenti più diffusi che sfrutta la potenza predittiva degli algoritmi di apprendimento automatizzato in abbinamento alle grandi moli di dati: i traduttori automatici.

È innegabile che negli ultimi anni tali strumenti siano migliorati in maniera impressionante, e le traduzioni automatiche di un testo da e verso differenti lingue, ottenute mediante tools di intelligenza artificiale come Google Translate, costituiscono in definitiva delle traduzioni “per lo più” affidabili.

Tuttavia è in quel “per lo più” che si nasconde il diavolo: anche se non affidabili al cento per cento, si suppone che tali traduzioni vengano interpretate da esseri umani “senzienti”, vale a dire in grado di comprendere il “senso” di tali traduzioni.

L’affidabilità statistica di tali traduzioni, in altri termini, rimanda ad operatori umani il compito di risolvere i casi limite più inconsueti, vale a dire quelli caratterizzati da maggiore ambiguità.

Mentre per la maggioranza dei casi ci si affida a regole meccaniche di derivazione delle regole di associazione tra differenti raggruppamenti di parole, inferite sulla base delle rispettive probabilità stimate.

In altre parole, il meccanismo di traduzione automatica ci fornisce “per lo più” la traduzione corretta, ma per le ragioni sbagliate.

Il traduttore automatico funziona non perchè esso sia in grado effettivamente di comprendere il senso del testo, ma perchè statisticamente è possibile istituire una relazione biunivoca sufficientemente affidabile tra le diverse rappresentazioni linguistiche dello stesso testo.

Salvo ovviamente nei “casi limite”, come ad es. nel caso delle metafore, delle espressioni ambigue o polisemiche, ecc.

Il punto critico è che, mentre nel caso delle traduzioni automatiche eventuali imprecisioni non sono suscettibili di mettere a repentaglio l’incolumità fisica degli esseri umani (anche se ne potremmo discutere…), non è altrettanto vero nel caso di imprecisioni nei risultati degli algoritmi dei veicoli a guida autonoma.

Quanto sono sicuri i veicoli a guida automa? Una domanda cui è ancora difficile rispondere

Da quanto abbiamo detto finora, appare evidente che non esiste una risposta facile su quanto in concreto possano essere sicure le auto a guida autonoma.

E la conferma della difficoltà a dare una risposta conclusiva alla domanda in questione, è arrivata anche da un recente rapporto stilato dal Center for Data Ethics and Innovation (CDEI) inglese, un organismo di esperti governativi che si occupa dell’innovazione affidabile utilizzando dati e intelligenza artificiale.

Secondo il CDEI, la domanda su quanto dovrebbero essere sicuri i veicoli autonomi non è una domanda alla quale la scienza possa rispondere da sola, ma che dovrebbe essere oggetto di un confronto democratico volto a contemperare le diverse opinioni e interessi in gioco.

Il bias degli algoritmi e la diversa esposizione ai rischi

Il CDEI afferma inoltre che è anche importante considerare come il rischio venga distribuito tra i diversi gruppi sociali.

Anche se ci fossero miglioramenti nella sicurezza generale, alcuni gruppi potrebbero assistere a miglioramenti sostanziali della sicurezza, mentre altri potrebbero non vederne nessuno o addirittura essere esposti a pericoli nuovi o inediti.

L’insorgenza di rischi inediti dovrà pertanto essere esaminata man mano che la tecnologia verrà implementata.

Tra questi vi è la possibilità di presenza di bias negli algoritmi che controllano le auto a guida autonoma, che potrebbero selezionare in maniera avversa alcuni gruppi e categorie sociali.

Ad esempio alcuni gruppi, come gli utenti su sedia a rotelle, potrebbero essere sottorappresentati nei dati utilizzati per addestrare gli algoritmi software che controllano le auto, causando potenziali pregiudizi.

La scarsa tolleranza al rischio verso i veicoli a guida autonoma

In generale il CDEI avverte che potrebbe non essere sufficiente che le auto a guida autonoma siano più sicure delle auto normali “soltanto” in media, richiedendo di conseguenza criteri di sicurezza più restrittivi.

Se il pubblico infatti si aspetta che le auto a guida autonoma siano sicure almeno quanto i treni o gli aerei, ciò richiederebbe un aumento stimato di almeno cento volte della sicurezza media, rispetto alle auto a guida manuale.

Il rapporto afferma inoltre che le auto a guida autonoma dovrebbero essere chiaramente identificate, in quanto le persone hanno il diritto di sapere con che tipo di agenti condividono la strada, riproponendo in forma inedita le questioni etiche attinenti il cosiddetto consenso informato.

Questo anche in relazione a come vengono condotti i test dei veicoli a guida autonoma su strade pubbliche, che potrebbero coinvolgere gli utenti della strada senza che questi ne abbiamo la dovuta consapevolezza.

Così come è importante coinvolgere l’opinione pubblica sui cambiamenti alle regole di circolazione indotti dall’introduzione di tali tecnologie innovative, che vanno ad impattare in maniera rilevante su convenzioni e consuetidini ormai considerate acquisite, le cui modifiche repentine potrebbero destabilizzare i comportamenti quotidiani con conseguenze impreviste in termini di sicurezza.

© Alessandro Parisi - All rights reserved - Riproduzione Riservata